Deepseek R1 هو نموذج لغوي كبير مفتوح المصدر (LLM) مصمم لمهام مثل الذكاء الاصطناعي الحواري، وتوليد الأكواد، وفهم اللغة الطبيعية. يضمن استخدام Deepseek R1 محليًا تحكمًا أكبر في خصوصية البيانات، ويقلل زمن الاستجابة، ويحسن الأداء. في هذا الدليل، سنشرح كيفية إعداد Deepseek R1 على جهازك المحلي باستخدام Ollama.

Deepseek R1 هو نموذج لغوي متقدم مدرَّب على معالجة النصوص وتوليدها بأسلوب يشبه اللغة البشرية. يمكن استخدامه في:

» توليد النصوص – لكتابة المقالات، الملخصات، والمزيد.

» مساعدة في البرمجة – لتوليد الأكواد وتصحيحها.

» فهم اللغة الطبيعية – لتحليل وتفسير مدخلات المستخدم.

» الإجابة عن الأسئلة – لتوفير ردود قائمة على السياق.

من خلال تشغيل Deepseek R1 محليًا، يمكنك التخلص من الاعتماد على الخدمات السحابية والحصول على تحكم كامل في سير عملك. الآن، لنستكشف كيفية إعداد Deepseek R1 على جهازك باستخدام Ollama.

» توليد النصوص – لكتابة المقالات، الملخصات، والمزيد.

» مساعدة في البرمجة – لتوليد الأكواد وتصحيحها.

» فهم اللغة الطبيعية – لتحليل وتفسير مدخلات المستخدم.

» الإجابة عن الأسئلة – لتوفير ردود قائمة على السياق.

من خلال تشغيل Deepseek R1 محليًا، يمكنك التخلص من الاعتماد على الخدمات السحابية والحصول على تحكم كامل في سير عملك. الآن، لنستكشف كيفية إعداد Deepseek R1 على جهازك باستخدام Ollama.

كيفية إعداد Deepseek R1 محليًا باستخدام Ollama

قبل أن نبدأ بعملية التثبيت، دعونا أولًا نفهم ما هو Ollama ولماذا يُفضل استخدامه لتشغيل Deepseek R1 محليًا.

ما هو Ollama؟

Ollama هو أداة خفيفة مصممة لتبسيط تشغيل نماذج الذكاء الاصطناعي محليًا. يوفر:

- إعدادًا سريعًا – يتطلب خطوات تثبيت بسيطة، مما يسمح بتشغيل النموذج بسرعة.

- استخدامًا محسّنًا للموارد – يدير الذاكرة بكفاءة لضمان أداء سلس.

- استدلالًا محليًا – لا حاجة لاتصال بالإنترنت بعد الإعداد.

لماذا استخدام Ollama؟

تشغيل Deepseek R1 باستخدام Ollama يوفر عدة مزايا:

- الخصوصية – تبقى بياناتك على جهازك.

- الأداء – استجابات أسرع بدون تأخير الخدمات السحابية.

- التخصيص – إمكانية ضبط سلوك النموذج لمهام محددة.

مع أخذ هذه الفوائد في الاعتبار، دعونا ننتقل إلى عملية التثبيت.

كيفية تثبيت Ollama

اتبع الخطوات التالية لتثبيت Ollama على نظامك:

macOS

افتح Terminal ثم نفّذ الأمر التالي:

إذا لم يكن Homebrew مثبتًا، قم بزيارة brew.sh واتبع تعليمات التثبيت.

كود:

brew install ollamaWindows & Linux

قم بتنزيل Ollama من الموقع الرسمي، ومن ثم اتبع دليل التثبيت الخاص بنظام التشغيل لديك.

بديلًا لذلك، يمكن لمستخدمي Linux تثبيته عبر Terminal باستخدام:

بعد تثبيت Ollama بنجاح، دعونا ننتقل إلى كيفية استخدام Deepseek R1 على جهازك المحلي.

بديلًا لذلك، يمكن لمستخدمي Linux تثبيته عبر Terminal باستخدام:

كود:

curl -fsSL https://ollama.com/install.sh | shتشغيل Deepseek R1 على Ollama

بمجرد تثبيت Ollama، اتبع هذه الخطوات لإعداد Deepseek R1 محليًا:

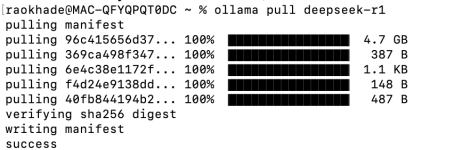

الخطوة 1: تنزيل نموذج Deepseek R1

لبدء استخدام Deepseek R1، يجب أولًا تنزيل النموذج. نفّذ الأمر التالي في Terminal:

للحصول على إصدار أصغر، حدد حجم النموذج كما يلي:

كود:

ollama pull deepseek-r1

كود:

ollama pull deepseek-r1:1.5bبعد تنزيل النموذج، يمكنك البدء في استخدامه.

الخطوة 2: تشغيل النموذج

بعد تنزيل النموذج، تحتاج إلى تشغيل خادم Ollama لتشغيل Deepseek R1. استخدم الأمر التالي:

ثم قم بتشغيل Deepseek R1 باستخدام:

لتشغيل إصدار معين، استخدم:

كود:

ollama serve

كود:

ollama run deepseek-r1

كود:

ollama run deepseek-r1:1.5bالخطوة 3: التفاعل مع Deepseek R1

بعد تشغيل النموذج، يمكنك التفاعل معه عبر Terminal. جرب الاستعلامات التالية:

كود:

ollama run deepseek-r1 "What is a class in C++?."حاول تجربة أوامر مختلفة لاكتشاف قدرات النموذج وكيف يمكنه تلبية احتياجاتك.

خاتمة

يُعد تشغيل Deepseek R1 محليًا باستخدام Ollama حلًا قويًا وخاصًا للذكاء الاصطناعي. من خلال اتباع هذا الدليل، يمكنك تثبيت النموذج، إعداده، والتفاعل معه بسلاسة على جهازك المحلي. سواء كنت بحاجة إلى توليد النصوص، البرمجة، أو استرجاع المعلومات، فإن Deepseek R1 يوفر تجربة ذكاء اصطناعي فعالة دون الاعتماد على الخدمات السحابية.