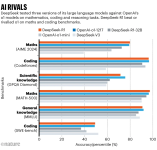

تُنتج هذه النماذج استجاباتها خطوة بخطوة، بطريقة مشابهة لعملية التفكير البشري. وهذا يجعلها أكثر كفاءة من النماذج اللغوية السابقة في حل المشكلات العلمية، مما قد يجعلها أداة مفيدة في الأبحاث. أظهرت الاختبارات الأولية للنموذج R1، الذي تم إصداره في 20 يناير، أن أداءه في بعض المهام المتعلقة بالكيمياء والرياضيات والبرمجة يضاهي أداء النموذج o1، الذي أثار إعجاب الباحثين عند إطلاقه من قبل OpenAI في سبتمبر.

كتب إلفيس سارافيا، الباحث في الذكاء الاصطناعي والمؤسس المشارك لشركة DAIR.AI الاستشارية في المملكة المتحدة، على منصة X قائلاً: "هذا أمر مذهل وغير متوقع تمامًا."

يتميز R1 بسبب آخر أيضًا. فقد أطلقت شركة DeepSeek، الناشئة في هانغتشو التي طوّرت النموذج، بوزن مفتوح، مما يعني أن الباحثين يمكنهم دراسة وتحسين الخوارزمية. تم نشره بترخيص MIT، مما يسمح بإعادة استخدامه بحرية، لكنه لا يُعتبر مفتوح المصدر بالكامل، نظرًا لعدم إتاحة بيانات تدريبه.

يقول ماريو كرين، قائد مختبر Artificial Scientist في معهد ماكس بلانك لعلوم الضوء في إرلانغن بألمانيا: "إن مستوى الانفتاح في DeepSeek مذهل للغاية." ويضيف أن نموذج o1 ونماذج OpenAI الأخرى، بما في ذلك أحدث إصدار o3، تعتبر "صناديق سوداء" لا يمكن الاطلاع على تفاصيلها.

لم تكشف DeepSeek عن التكلفة الكاملة لتدريب R1، لكنها تفرض رسومًا على استخدام واجهتها تعادل حوالي واحد على ثلاثين من تكلفة تشغيل نموذج o1. كما أن الشركة طورت إصدارات صغيرة "مقطرة" من R1 لتمكين الباحثين ذوي القدرة الحاسوبية المحدودة من تجربة النموذج. يقول ماريو كرين: "التجربة التي كلفت أكثر من 300 جنيه إسترليني مع o1، كلفت أقل من 10 دولارات مع R1. هذا فارق كبير من المؤكد أنه سيلعب دورًا في تبني النموذج مستقبلًا."

كتب إلفيس سارافيا، الباحث في الذكاء الاصطناعي والمؤسس المشارك لشركة DAIR.AI الاستشارية في المملكة المتحدة، على منصة X قائلاً: "هذا أمر مذهل وغير متوقع تمامًا."

يتميز R1 بسبب آخر أيضًا. فقد أطلقت شركة DeepSeek، الناشئة في هانغتشو التي طوّرت النموذج، بوزن مفتوح، مما يعني أن الباحثين يمكنهم دراسة وتحسين الخوارزمية. تم نشره بترخيص MIT، مما يسمح بإعادة استخدامه بحرية، لكنه لا يُعتبر مفتوح المصدر بالكامل، نظرًا لعدم إتاحة بيانات تدريبه.

يقول ماريو كرين، قائد مختبر Artificial Scientist في معهد ماكس بلانك لعلوم الضوء في إرلانغن بألمانيا: "إن مستوى الانفتاح في DeepSeek مذهل للغاية." ويضيف أن نموذج o1 ونماذج OpenAI الأخرى، بما في ذلك أحدث إصدار o3، تعتبر "صناديق سوداء" لا يمكن الاطلاع على تفاصيلها.

لم تكشف DeepSeek عن التكلفة الكاملة لتدريب R1، لكنها تفرض رسومًا على استخدام واجهتها تعادل حوالي واحد على ثلاثين من تكلفة تشغيل نموذج o1. كما أن الشركة طورت إصدارات صغيرة "مقطرة" من R1 لتمكين الباحثين ذوي القدرة الحاسوبية المحدودة من تجربة النموذج. يقول ماريو كرين: "التجربة التي كلفت أكثر من 300 جنيه إسترليني مع o1، كلفت أقل من 10 دولارات مع R1. هذا فارق كبير من المؤكد أنه سيلعب دورًا في تبني النموذج مستقبلًا."

تحدي النماذج المنافسة

يعد R1 جزءًا من الطفرة التي تشهدها الصين في مجال النماذج اللغوية الكبيرة (LLMs). فقد خرجت DeepSeek، التي انبثقت من صندوق تحوط، من دائرة المجهول الشهر الماضي عندما أطلقت روبوت الدردشة V3، الذي تفوق على منافسين رئيسيين، رغم تطويره بميزانية محدودة. يقدر الخبراء أن تدريب النموذج كلّف حوالي 6 ملايين دولار لاستئجار العتاد اللازم، مقارنة بأكثر من 60 مليون دولار لنموذج Llama 3.1 405B التابع لشركة Meta، والذي استخدم موارد حسابية تفوق نظيره بـ 11 مرة.

جزء من الإثارة حول DeepSeek يرجع إلى نجاحها في تطوير R1 رغم قيود التصدير الأمريكية التي تحد من وصول الشركات الصينية إلى أفضل الرقائق الحاسوبية المصممة لمعالجة الذكاء الاصطناعي. يقول فرانسوا شوليه، الباحث في الذكاء الاصطناعي في سياتل بواشنطن: "حقيقة أن النموذج خرج من الصين تُظهر أن كفاءة استخدام الموارد أكثر أهمية من مجرد امتلاك قوة حسابية هائلة."

يكتب ألفين وانغ غرايلين، الخبير التكنولوجي في بلفيو بواشنطن، والذي يعمل لدى شركة HTC التايوانية للتكنولوجيا الغامرة، على منصة X: "يشير تقدم DeepSeek إلى أن الفجوة التي كان يُعتقد أن الولايات المتحدة تتفوق بها قد تقلصت بشكل كبير." ويضيف: "يجب على البلدين اتباع نهج تعاوني في بناء الذكاء الاصطناعي المتقدم بدلًا من الاستمرار في سباق تسلح لا رابح فيه."

جزء من الإثارة حول DeepSeek يرجع إلى نجاحها في تطوير R1 رغم قيود التصدير الأمريكية التي تحد من وصول الشركات الصينية إلى أفضل الرقائق الحاسوبية المصممة لمعالجة الذكاء الاصطناعي. يقول فرانسوا شوليه، الباحث في الذكاء الاصطناعي في سياتل بواشنطن: "حقيقة أن النموذج خرج من الصين تُظهر أن كفاءة استخدام الموارد أكثر أهمية من مجرد امتلاك قوة حسابية هائلة."

يكتب ألفين وانغ غرايلين، الخبير التكنولوجي في بلفيو بواشنطن، والذي يعمل لدى شركة HTC التايوانية للتكنولوجيا الغامرة، على منصة X: "يشير تقدم DeepSeek إلى أن الفجوة التي كان يُعتقد أن الولايات المتحدة تتفوق بها قد تقلصت بشكل كبير." ويضيف: "يجب على البلدين اتباع نهج تعاوني في بناء الذكاء الاصطناعي المتقدم بدلًا من الاستمرار في سباق تسلح لا رابح فيه."

سلسلة التفكير

تُدرب النماذج اللغوية الكبيرة (LLMs) على مليارات العينات النصية، حيث تُقسِّم النصوص إلى أجزاء تُعرف باسم "التوكنات" (tokens) وتتعلم الأنماط في البيانات. تساعد هذه الارتباطات النموذج في التنبؤ بالتوكنات التالية في الجملة. ومع ذلك، فإن النماذج اللغوية غالبًا ما تخترع معلومات غير صحيحة، وهي ظاهرة تُعرف بـ**"الهلوسة"**، كما أنها تواجه صعوبات في حل المشكلات بشكل منطقي.

على غرار o1، يستخدم R1 طريقة "سلسلة التفكير" لتحسين قدرته على حل المهام المعقدة، حيث يمكنه أحيانًا إعادة تقييم استنتاجاته والتراجع عن الخطوات غير الصحيحة. قامت DeepSeek بتطوير R1 عن طريق "تحسين الضبط" (fine-tuning) لنموذج V3 باستخدام التعلم المعزز (reinforcement learning)، حيث تم مكافأة النموذج عند الوصول إلى إجابة صحيحة، وأيضًا عند حل المشكلات بطريقة تبرز تسلسل "تفكيره".

على غرار o1، يستخدم R1 طريقة "سلسلة التفكير" لتحسين قدرته على حل المهام المعقدة، حيث يمكنه أحيانًا إعادة تقييم استنتاجاته والتراجع عن الخطوات غير الصحيحة. قامت DeepSeek بتطوير R1 عن طريق "تحسين الضبط" (fine-tuning) لنموذج V3 باستخدام التعلم المعزز (reinforcement learning)، حيث تم مكافأة النموذج عند الوصول إلى إجابة صحيحة، وأيضًا عند حل المشكلات بطريقة تبرز تسلسل "تفكيره".

امتلاك قدرة حوسبية محدودة دفع الشركة إلى "الابتكار خوارزميًا"، كما يقول ويندا لي، باحث في الذكاء الاصطناعي بجامعة إدنبرة في المملكة المتحدة. خلال التعلم المعزز، قام الفريق بتقدير تقدم النموذج في كل مرحلة بدلاً من تقييمه باستخدام شبكة منفصلة. ساعد هذا في تقليل تكاليف التدريب والتشغيل، كما يقول ماتيجا جامنيك، عالم الحاسوب في جامعة كامبريدج في المملكة المتحدة. كما استخدم الباحثون بنية "مزيج الخبراء"، والتي تسمح للنموذج بتفعيل الأجزاء ذات الصلة فقط لكل مهمة.

في الاختبارات المعيارية، كما ورد في ورقة بحثية تقنية مرافقة للنموذج، حصل DeepSeek-R1 على 97.3٪ في مجموعة مسائل الرياضيات MATH-500 التي أنشأها باحثون في جامعة كاليفورنيا، بيركلي، وتفوق على 96.3٪ من المشاركين البشريين في مسابقة Codeforces. هذه النتائج تعادل تقريبًا قدرات o1؛ لم يتم تضمين o3 في المقارنات (انظر "للصورة بالاعلى").

من الصعب تحديد ما إذا كانت المعايير تقيس قدرة النموذج الحقيقية على الاستدلال أو التعميم، أو مجرد اجتيازه لهذه الاختبارات. ولكن نظرًا لأن R1 مفتوح، فإن "سلسلة التفكير" الخاصة به متاحة للباحثين، كما يقول ماركو دوس سانتوس، عالم الحاسوب في جامعة كامبريدج. "هذا يسمح بفهم أفضل لعمليات الاستدلال الخاصة بالنموذج"، كما يقول.

بدأ العلماء بالفعل في اختبار قدرات R1. تحدى كرين كلا النموذجين المتنافسين بفرز 3000 فكرة بحثية بناءً على مدى إثارتها للاهتمام، وقارن النتائج مع التصنيفات التي وضعها البشر. في هذا القياس، كان أداء R1 أقل قليلاً من o1. لكن R1 تفوق على o1 في بعض العمليات الحسابية في البصريات الكمومية، كما يقول كرين. "هذا أمر مثير للإعجاب."

المصدر: مجلة Nature